Хороший, поганий, регульований АІ. Що важливо знати про перший акт, який регулює використання штучного інтелекту?

Світ увійшов в еру штучного інтелекту, що впевнено «відчиняє двері» в кожну сферу нашого життя і змінює способи, в які ми звикли працювати, створювати та підтримувати. Розробники й технологічні гіганти невпинно працюють над новими продуктами, а позначка «AI based» гарантує суттєвий приплив інтересу та інвестицій до ваших бізнес-рішень.

Та з великою силою приходить велика відповідальність. З одного боку AI – це помічник в умілих руках, що може покращити якість життя, збільшити продуктивність, сприяти інноваціям та конкурентоспроможності, але він також може створювати ризики для прав людини, демократії, безпеки та ринку. Тому потрібен баланс між сприянням розвитку AI та забезпеченням його відповідального використання.

Використання терміну “штучний інтелект” у назві продукту або послуги вже давно перестало бути чимось незвичайним. Сьогодні це майже обов’язкова умова для досягнення успіху та визнання сучасності. За останній рік технології АІ стали доступнішими для широкого загалу, як це демонструє приклад ChatGPT, а їх використання потребує все менше технічної підготовки.

Багато технологічних гігантів, зокрема Microsoft, розробляють інтуїтивно зрозумілі інструменти для взаємодії з потужними моделями АІ. Наприклад, Azure AI Studio – це платформа для розгортання популярних моделей АІ, а Azure ML Studio – платформа для машинного навчання. Завдяки таким рішенням компанії можуть змістити фокус з адміністрування та розгортання на безпосередню взаємодію з платформою та її налаштуваннями. Це не тільки скорочує час на впровадження рішень, але й підвищує рівень безпеки та захисту інформації.

Ми дослідили питання та хочемо розказати, які ризики несе нерегульоване використання технологій штучного інтелекту для бізнесу й людини, а також про перший європейський закон, що контролює використання AI-технологій.

Ризики використання AI для бізнесу за відсутності регуляції

Ризики для бізнесу

- Неточні рішення або прогнози через помилки алгоритмів

Алгоритми AI можуть припускатися помилок або ж приймати рішення на основі неточних даних. Це може призвести до болючих фінансових втрат, невдалих стратегічних рішень або навіть до репутаційних ризиків. Наприклад, неточне прогнозування попиту на певну SKU може вартувати ритейлеру значних фінансових ризиків та потенційних списань. Як уникнути? Накопичувати історичні дані, які допоможуть робити прогнози точнішими, тестувати та використовувати перевірені системи, як-от SMART Demand Forecast від SMART business. - Кібербезпека

AI може бути використаний для здійснення складних кібератак, що може поставити під загрозу інфраструктуру, дані та ресурси як бізнесу, так і державного апарату будь-якої країни. Звичайно, цього можна уникнути, якщо потурбуватись про комплексний захист вашого бізнесу та регулярно нагадувати співробітникам про security-гігієну. - Юридичні та етичні проблеми

Використання технологій штучного інтелекту може порушувати закони та регулювальні акти про конфіденційність та захист даних (GDPR, CCPA, VCDPA, SOC та інші), особливо якщо дані збираються або використовуються без належного дозволу. Як результат – часткова або повна втрата довіри клієнтів, репутаційні ризики, ба навіть юридичні санкції. Тому слід використовувати корпоративні та захищені версії генеративних моделей, таких як Azure OpenAI. - Залежність від технологій

Надмірне використання інструментів штучного інтелекту може знизити здатність співробітників до критичного мислення та прийняття рішень, а це вже може негативно вплинути на гнучкість та адаптивність бізнесу. До того ж big brother Google стежить за вами, адже має достатньо інструментів для перевірки вашого контенту, щоб визначити відсоток залучення AI. Не зліть Google, бо будете покарані як прецедентна агенція, чиє надмірне захоплення AI для генерації тисячі постів було ідентифіковано корпорацією та покарано.

Використання АІ, до прикладу, в рамках екосистеми Microsoft, дозволяє компаніям повністю контролювати роботу з корпоративними та конфіденційними даними, а також забезпечує можливість регулювання результатів. Такі переваги є критично важливими для бізнесу, адже вони дозволяють мінімізувати ризики, пов’язані з витоком даних та несанкціонованим доступом.

Те, що ми бачимо зараз – це лише початок масштабної історії розвитку АІ. Спілкуючись з клієнтами, ми бачимо, що всі, без винятку, розглядають великі перспективи використання АІ у своїх бізнес-процесах. Деякі компанії вже активно впроваджують ці технології, тоді як інші ще шукають оптимальні рішення

Ризики для людини

- Порушення приватності. Технології AI можуть бути використані для масового спостереження та аналізу персональних даних без згоди людей. А це вже порушує конфіденційність та приватність.

- Дискримінація та упередженість. AI-алгоритми можуть підсилювати наявні соціальні упередження щодо певних груп людей. Це може призвести до дискримінації за віковою, расовою, гендерною чи іншими ознаками. Ні, дякую.

- Втрата робочих місць. Мабуть, найбільший страх людства пов’язаний із можливістю конкуренції з AI. Автоматизація процесів може в перспективі означати скорочення робочих місць у сферах, де людину безболісно замінити машиною.

- Психологічний вплив. Постійний контроль та моніторинг за допомогою інструментів штучного інтелекту можуть викликати стрес та відчуття недовіри у людей. А надмірне захоплення технологіями знижує рівень соціальної взаємодії та викликає почуття ізольованості від зовнішнього світу. Що занадто – не здорово.

Ризики та їхні потенційні наслідки виглядають доволі вагомим аргументом, щоб уряди країн світу ініціювали процес регуляції технологій генеративного AI на державному рівні. Адже лише регулювання та фіксовані етичні стандарти можуть забезпечити баланс між технологічним прогресом та захистом прав людини й бізнесу.

З чого починаємо?

Шлях до регуляції генеративного AI

Ще у грудні 2023 року політики та міністри країн Європейського союзу досягли згоди щодо основних спірних моментів закону. Основні цілі, що спонукали до необхідності закону про штучний інтелект в ЄС, можна звести до трьох основних пунктів:

- Довіра. Гарантувати, що європейські громадяни можуть довіряти технологіям штучного інтелекту та їх практичному застосуванню.

- Управління ризиками. Створити основу для управління потенційними ризиками протягом усього життєвого циклу систем на основі АІ, особливо тих, які класифікуються як високоризиковані.

- Упорядкування. Забезпечити єдині правила для систем штучного інтелекту в ЄС, гарантуючи узгодженість стандартів у державах-членах.

Однак зелене світло для подальшого ухвалення акту не було гарантоване, адже деякі європейські важковаговики до останніх днів чинили опір окремим частинам угоди.

Головним противником була Франція, яка разом із Німеччиною та Італією просила пом’якшити режим регулювання для потужних моделей AI, таких як GPT-4 від OpenAI, що підтримують системи AI загального призначення, як-от ChatGPT та Bard. Така позиція трьох найбільших європейських економік була обумовлена побоюваннями «підрізати крила» перспективним європейським стартапам, як-от Mistral AI та Aleph Alpha, які можуть кинути виклик американським компаніям галузі. Однак Європарламент одностайно зажадав жорстких правил для всіх моделей без винятків.

Все ж, 21 травня Рада ЄС остаточно схвалила Artificial Intelligence Act (AI Act), за який 13 березня проголосував Європарламент. Основна мета регламенту — захистити фундаментальні права, демократію, верховенство права та екологічну стійкість від ризиків, які може нанести AI.

Європейський приклад Закону про штучний інтелект (AI Act) вже називають еталоном у сфері регулювання технологій і прогнозують, що він стане зразком та робочим шаблоном для законодавців усього світу. Дія цього закону поширюється на всі сектори економіки, за винятком військового, і охоплює всі типи штучного інтелекту.

Основні ідеї Artificial Intelligence Act

Нові правила матимуть серйозні наслідки для будь-якої фізичної чи юридичної особи, яка розробляє, використовує або продає системи штучного інтелекту в ЄС. Таким чином, прийняття закону має дві основні цілі:

1) сприяти розвитку штучного інтелекту, інвестиціям та інноваціям у цій сфері завдяки чіткому правовому регулюванню;

2) усунути або мінімізувати ризики, пов’язані з використанням AI-технологій.

У Європарламенті зазначають, що правила AI Act забороняють використовувати обличчя з інтернету та відеоспостереження для створення баз даних розпізнавання облич. Також заборонять маніпулювати поведінкою, вразливостями людей та розпізнавати емоції за допомогою моделей штучного інтелекту.

Із важливого, також Artificial Intelligence Act накладає жорсткі обмеження на генеративні системи AI «загального призначення» (General purpose AI, GPAI). Зокрема, це вимоги дотримання закону ЄС про авторське право, розкриття інформації щодо того, як навчаються моделі, регулярне тестування та адекватне дотримання кібербезпеки.

Звичайно, обмеження почнуть діяти не одразу, а лише через 12 місяців після набрання законом чинності. І навіть тоді комерційно доступні генеративні моделі, як ChatGPT від OpenAI, Gemini від Google і Copilot від Microsoft, отримають «перехідний період» у 36 місяців, щоб привести свою технологію у відповідність до законодавства.

Що зміниться для бізнесу та держави?

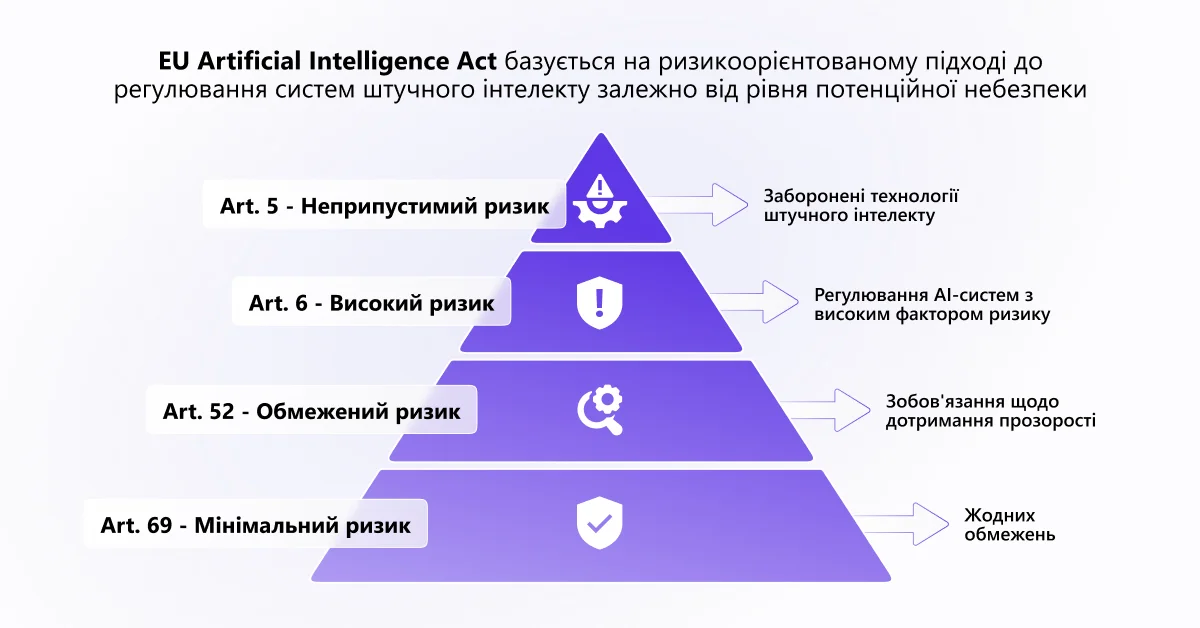

Artificial Intelligence Act базується на ризикоорієнтованому підході, який розрізняє основні категорії систем штучного інтелекту на основі ймовірності заподіяти шкоду та потенційному рівню її тяжкості:

- Неприпустимий ризик. До заборонених систем генеративного АІ потрапили моделі з неприйнятним рівнем ризику для безпеки, прав або основних свобод людини, що можуть:

- маніпулювати поведінкою людей або вразливих груп;

- обити соціальне ранжування людей за поведінкою, соціально-економічним статусом чи особистими характеристиками;

- робити біометричну ідентифікацію та категоризацію людей, розпізнавання облич.

- Високий ризик. Такі системи потребують суворого регулювання та нагляду протягом усього життєвого циклу. Наприклад, це моделі, які можуть використовуватись у:

- критичній інфраструктурі (транспорт);

- освіті та професійній підготовці та впливають на доступ до неї, працевлаштуванні;

- медицині (AI у хірургії з використанням роботизованих технологій);

- наданні приватних та державних послуг (скоринг кредитів);

- правоохоронній діяльності, що може порушувати основні права людини;

- управлінні міграцією, наданні притулку та прикордонному контролі;

- здійсненні правосуддя та демократичних процесах.

- Обмежений ризик. АІ-системи з цієї категорії все ще вимагають дотримання певних заходів безпеки, як-от попередження про використання, однак нормативні вимоги до цих систем менш суворі. Наприклад, чат-боти для обслуговування клієнтів на основі штучного інтелекту або ж системи для виявлення емоцій й ті, що створюють контент категорії deep fakes.

- Мінімальний ризик. Такі моделі генеративного штучного інтелекту підпадають під найменший нормативний тягар. Сюди, до прикладу, відносимо основні фільтри електронної пошти, які класифікують повідомлення як спам.

Системи штучного інтелекту загального призначення (GPAI) – це, зокрема, Copilot, ChatGPT та Gemini. Вони можуть створювати системні ризики та повинні проходити процес ретельної оцінки. Також додатковим регламентом тепер буде дотримання вимог прозорості та авторського права ЄС, запобігання генеруванню незаконного контенту. Контент згенерований за допомогою AI має бути додатково позначений, а аудиторія проінформована про це. Маркетологи, беріть до уваги!

Нові регулятори

Комісія ЄС відтепер має повне право штрафувати компанії за порушення закону на суми до 35 мільйонів євро або 7% річного глобального доходу компанії. Для малих і середніх підприємств передбачена нижча шкала штрафів, враховуючи їхні інтереси та економічну життєздатність.

Контроль за виконанням закону здійснюватиме новостворене Управління з питань штучного інтелекту (AI Office) на рівні ЄС. Це управління матиме повноваження оцінювати моделі загального призначення (GPAI) та допомагати національним органам влади в нагляді за ринком високоризикових систем генеративного AI. Також створено Європейську раду зі штучного інтелекту, що складається з представників держав-членів ЄС і відповідатиме за надання консультацій, висновків та рекомендацій.

Що робити бізнесу? Висновки та рекомендації

Якщо ви є постачальником, розробником, імпортером, дистриб’ютором або ж особою, на яку поширюються системи штучного інтелекту, вам необхідно переконатися, що ваша практика використання штучного інтелекту відповідає новим вимогам закону. Тому ми пропонуємо кілька практичних кроків, з яких ви можете почати вже зараз:

Оцініть свої ризики. Переконайтеся, що ваша організація має комплексну систему управління ризиками відповідно до вимог Закону про штучний інтелект та застосовуйте відповідні вимоги щодо якості даних, технічної документації, людського нагляду, роботи зі стейкхолдерами тощо.

Прозорість та зрозумілість AI-систем. Інформуйте користувачів та інших зацікавлених сторін про використання AI, його можливості та обмеження, а також надайте їм можливість оскаржувати та виправляти рішення, що ґрунтуються на AI.

Підвищуйте обізнаність. Поширюйте інформацію та навчайте своїх співробітників щодо користі та ризиків, пов’язаних зі штучним інтелектом.

Побудова етичних стандартів. Сприяйте сталому та етичному використанню AI, інтегруючи це у стратегію вашої організації.

Тримайте руку на пульсі. Стежте за новими регуляторними змінами, щоб передбачити їхній вплив на вашу діяльність та забезпечити своєчасне дотримання вимог.

AI Act – це частина нової європейської цифрової стратегії, яка, крім ШІ, зачіпає й інші аспекти цифрового світу. Як і GDPR, CCPA та інші регулювальні акти, Закон поширюватиметься на всі компанії, які планують вихід на європейський ринок. Він має на меті створити екосистему AI, яка буде відповідати європейським цінностям та правилам, а також сприяти інноваціям та конкурентоспроможності.

Ми як партнери корпорації Microsoft спостерігаємо за розвитком подій та сприяємо етичному поширенню та використанню генеративного AI, що наразі стає невіддільною частиною рішень, додатків та сервісів як Microsoft, так SMART business.

Яка позиція Майкрософт щодо створення моделі управління та регулювання технології ШІ в Європі? Корпорація Майкрософт бере активну участь у дискусіях щодо регулювання штучного інтелекту, надаючи пропозиції, що ґрунтуються на досвіді роботи з клієнтами та власній відповідальній програмі штучного інтелекту (responsible AI program).

Корпорація Майкрософт розширила свій план з п’яти пунктів, який вона вперше представила у 2019 році, щоб показати, як він узгоджується з дискусіями щодо Закону ЄС про штучний інтелект. План включає такі принципи як відповідальність, прозорість, справедливість, надійність та безпека.

У своєму офіційному блозі Майкрософт заявляє що підтримує такий регуляторний режим в Європі, який би ефективно вирішував питання безпеки та захищав основні права, водночас продовжуючи сприяти інноваціям, які забезпечать конкурентоспроможність Європи на глобальному рівні.

Корпорація взяла на себе зобов’язання впровадити систему управління ризиками штучного інтелекту (NIST) та інші міжнародні стандарти безпеки, які будуть зазначені в Законі про штучний інтелект

Всі продукти в портфелі SMART business відповідають вимогам як локальних, так і міжнародних стандартів й регулювальних норм, що нівелює ризики клієнтів і допомагає безпечно та легально керувати бізнес-процесами. Ми завжди готові стати вашим надійним ІТ-партнером і допомогти із full cycle впровадженням та підтримкою:

- ERP для автоматизації бізнес-процесів;

- Кадрового обліку та нарахування зарплати;

- Управління людським капіталом;

- Внутрішнього корпоративного порталу;

- Microsoft 365 та Copilot for Microsoft 365;

- Програмами адаптації до роботи в Microsoft 365;

- Microsoft Azure;

- Прогнозуванням попиту;

- Комплексним захистом IT-безпеки компанії;

- Системами електронного документообігу;

- Системами управління складом.