Dobra, zła i uregulowana sztuczna inteligencja. Co warto wiedzieć o pierwszej ustawie regulującej wykorzystanie sztucznej inteligencji?

Świat wkroczył w erę sztucznej inteligencji, która zdecydowanie „otwiera drzwi” do każdej sfery naszego życia i zmienia sposoby, w jakie pracujemy, tworzymy i wspieramy. Deweloperzy i giganci technologiczni nieustannie pracują nad nowymi produktami, a oznaczenie „AI based” gwarantuje znaczny napływ zainteresowania i inwestycji w Twoje rozwiązania biznesowe.

Z wielką mocą wiąże się jednak wielka odpowiedzialność. Z jednej strony sztuczna inteligencja jest pomocnikiem we właściwych rękach, który może poprawić jakość życia, zwiększyć produktywność, promować innowacje i konkurencyjność, ale może również stanowić zagrożenie dla praw człowieka, demokracji, bezpieczeństwa i rynku. Dlatego też potrzebna jest równowaga między promowaniem rozwoju sztucznej inteligencji a zapewnieniem jej odpowiedzialnego wykorzystania.

Użycie terminu «sztuczna inteligencja» w nazwie produktu lub usługi już dawno przestało być czymś niezwykłym. Dziś jest to niemal warunek konieczny do osiągnięcia sukcesu i uznania we współczesnym świecie. W ciągu ostatniego roku technologie AI stały się bardziej dostępne dla szerokiej publiczności, jak pokazuje ChatGPT, a ich użycie wymaga coraz mniej umiejętności technicznych.

Wielu gigantów technologicznych, w tym Microsoft, opracowuje intuicyjne narzędzia do interakcji z potężnymi modelami AI. Na przykład Azure AI Studio to platforma do wdrażania popularnych modeli AI, a Azure ML Studio to platforma uczenia maszynowego. Dzięki takim rozwiązaniom firmy mogą skupić się na bezpośredniej interakcji z platformą i jej ustawieniami, zamiast na administrowaniu i wdrażaniu. To nie tylko skraca czas wdrożenia rozwiązań, ale także zwiększa poziom bezpieczeństwa i ochrony informacji.

Zbadaliśmy tę kwestię i chcielibyśmy opowiedzieć o zagrożeniach związanych z nieuregulowanym wykorzystaniem technologii sztucznej inteligencji dla biznesu i ludzi, a także o pierwszej europejskiej ustawie, która reguluje wykorzystanie technologii AI.

Ryzyko związane z wykorzystaniem AI w biznesie przy braku regulacji prawnych

Ryzyko dla biznesu

- Nietrafne decyzje lub prognozy z powodu błędów algorytmów.

Algorytmy AI mogą popełniać błędy lub podejmować decyzje na podstawie nieprecyzyjnych danych. Może to prowadzić do bolesnych strat finansowych, nieudanych decyzji strategicznych, a nawet ryzyk reputacyjnych. Na przykład niedokładne prognozowanie popytu na określone produkty SKU może narazić sprzedawcę detalicznego na znaczne ryzyko finansowe i potencjalne straty. Jak tego uniknąć? Zbieraj dane historyczne, które pomogą zwiększyć dokładność prognoz, testuj i korzystaj ze sprawdzonych systemów, takich jak SMART Demand Forecast od SMART business. - Cyberbezpieczeństwo.

Sztuczna inteligencja może być wykorzystywana do przeprowadzania zaawansowanych cyberataków, które mogą zagrozić infrastrukturze, danym i zasobom zarówno firm, jak i instytucji państwowych w każdym kraju. Oczywiście można tego uniknąć, dbając o kompleksową ochronę firmy i regularnie przypominając pracownikom o przestrzeganiu zasad cyberbezpieczeństwa. - Kwestie prawne i etyczne

Korzystanie z technologii sztucznej inteligencji może naruszać przepisy i regulacje dotyczące prywatności i ochrony danych (RODO, CCPA, VCDPA, SOC itp.), zwłaszcza jeśli dane są zbierane lub używane bez odpowiedniego pozwolenia. W rezultacie może dojść do utraty zaufania klientów, ryzyk reputacyjnych, a nawet sankcji prawnych. Dlatego warto używać korporacyjnych i zabezpieczonych wersji modeli generatywnych, takich jak Azure OpenAI. - Uzależnienie od technologii

Nadmierne korzystanie z narzędzi sztucznej inteligencji może zmniejszyć zdolność pracowników do krytycznego myślenia i podejmowania decyzji, co już może mieć negatywny wpływ na elastyczność biznesową i zdolności adaptacyjne. Poza tym, „big brother” Google obserwuje Cię, ponieważ ma wystarczająco dużo narzędz, aby sprawdzić Twoje treści w celu określenia procentu zaangażowania sztucznej inteligencji. Nie denerwuj Google, bo zostaniesz ukarany jako precedensowa agencja, której nadmierne poleganie na sztucznej inteligencji do generowania tysięcy postów zostało zidentyfikowane i ukarane przez korporację.

Wykorzystanie sztucznej inteligencji, na przykład w ekosystemie Microsoft, pozwala firmom w pełni kontrolować przetwarzanie danych korporacyjnych i poufnych, a także zapewnia możliwość kontrolowania wyników. Takie korzyści są kluczowe dla biznesu, ponieważ pozwalają zminimalizować ryzyka związane z wyciekiem danych i nieautoryzowanym dostępem.

To, co widzimy teraz, to dopiero początek wielkiej historii rozwoju AI. Rozmawiając z klientami, widzimy, że wszyscy, bez wyjątku, dostrzegają wielkie perspektywy wykorzystania AI w swoich procesach biznesowych. Niektóre firmy już aktywnie wdrażają te technologie, podczas gdy inne wciąż szukają optymalnych rozwiązań.

Ryzyko dla ludzi

- Naruszenie prywatności. Technologie AI mogą być wykorzystywane do masowego nadzoru i analizy danych osobowych bez zgody ludzi. Narusza to poufność i prywatność.

- Dyskryminacja i uprzedzenia. Algorytmy AI mogą wzmacniać istniejące społeczne uprzedzenia wobec określonych grup ludzi. Może to prowadzić do dyskryminacji ze względu na wiek, rasę, płeć lub inne cechy. Nie, dziękujemy.

- Utrata miejsc pracy. Największym lękiem związanym z AI jest możliwość konkurencji z maszynami. Automatyzacja procesów może w przyszłości oznaczać redukcję miejsc pracy w obszarach, gdzie człowieka można łatwo zastąpić maszyną.

- Wpływ psychologiczny. Ciągły nadzór i monitoring za pomocą narzędzi AI mogą powodować stres i brak zaufania u ludzi. Nadmierne korzystanie z technologii obniża poziom interakcji społecznych i powoduje izolację od świata zewnętrznego. Co za dużo, to niezdrowo.

Ryzyka i ich potencjalne konsekwencje stanowią wystarczająco ważny argument, by rządy na całym świecie inicjowały proces regulacji technologii generatywnej AI na poziomie państwowym. Tylko regulacje i określone standardy etyczne mogą zapewnić równowagę między postępem technologicznym a ochroną praw człowieka i biznesu.

Od czego zacząć?

Droga do regulacji generatywnej AI

Jeszcze w grudniu 2023 roku politycy i ministrowie krajów Unii Europejskiej osiągnęli porozumienie w kwestii głównych kontrowersyjnych punktów ustawy. Główne cele, które skłoniły do potrzeby ustawy o sztucznej inteligencji w UE, można podsumować w trzech punktach:

- Zaufanie. Zapewnienie, że obywatele europejscy mogą ufać technologiom sztucznej inteligencji i ich praktycznemu zastosowaniu.

- Zarządzanie ryzykiem. Określenie zasad zarządzania potencjalnym ryzykiem przez cały cykl życia systemów opartych na AI, zwłaszcza tych sklasyfikowanych jako obarczone wysokim ryzykiem.

- Ujednolicenie. Zapewnienie jednolitych zasad dla systemów AI w UE, gwarantując spójność standardów w państwach członkowskich.

Jednak zielone światło dla dalszego przyjęcia ustawy nie było gwarantowane, ponieważ niektóre kraje europejskie do ostatnich dni opierały się niektórym częściom porozumienia.

Głównym przeciwnikiem była Francja, która wraz z Niemcami i Włochami prosiła o złagodzenie regulacji dla potężnych modeli AI, takich jak GPT-4 od OpenAI, wspierających systemy AI ogólnego przeznaczenia, takie jak ChatGPT i Bard. Przyczyną takiego postępowania trzech największych europejskich gospodarek była obawa przed „podcięciem skrzydeł” obiecującym europejskim startupom, takim jak Mistral AI i Aleph Alpha, które mogłyby rzucić wyzwanie amerykańskim firmom z tej branży. Parlament Europejski jednogłośnie zażądał jednak surowych zasad dla wszystkich modeli bez wyjątku.

Niemniej jednak, 21 maja Rada UE ostatecznie zatwierdziła Artificial Intelligence Act (AI Act), za którą Parlament Europejski głosował 13 marca. Głównym celem regulacji jest ochrona podstawowych praw, demokracji, praworządności oraz zrównoważonego rozwoju przed ryzykami związanymi z AI.

Europejski przykład Ustawy o sztucznej inteligencji (AI Act) już jest uznawany za wzór w dziedzinie regulacji technologii i prognozuje się, że stanie się wzorcem dla ustawodawców na całym świecie. Ustawa obejmuje wszystkie sektory gospodarki, z wyjątkiem wojskowego, i dotyczy wszystkich typów sztucznej inteligencji.

Główne założenia Artificial Intelligence Act

Nowe przepisy będą miały poważne konsekwencje dla każdej osoby fizycznej lub prawnej, która opracowuje, wykorzystuje lub sprzedaje systemy sztucznej inteligencji w UE. Przyjęcie ustawy ma zatem dwa główne cele:

1) promowanie rozwoju sztucznej inteligencji, inwestycji i innowacji w tym obszarze poprzez jasne regulacje prawne;

2) wyeliminowanie lub zminimalizowanie ryzyka związanego z wykorzystaniem technologii sztucznej inteligencji.

Parlament Europejski zaznacza, że przepisy AI Act zakazują używania twarzy z internetu i monitoringu wideo do tworzenia baz danych rozpoznawania twarzy. Zabronione będzie również manipulowanie zachowaniem, wrażliwościami ludzi oraz rozpoznawanie emocji za pomocą modeli AI.

Co ważne, Artificial Intelligence Act nakłada ścisłe ograniczenia na generatywne systemy AI „ogólnego przeznaczenia” (General Purpose AI, GPAI). Wymaga to przestrzegania prawa UE dotyczącego praw autorskich, ujawniania informacji na temat sposobu trenowania modeli, regularnego testowania oraz adekwatnego przestrzegania zasad cyberbezpieczeństwa.

Oczywiście, ograniczenia te nie wejdą w życie od razu, lecz dopiero 12 miesięcy po wejściu ustawy w życie. Nawet wtedy komercyjnie dostępne modele generatywne, takie jak ChatGPT od OpenAI, Gemini od Google i Copilot od Microsoftu, otrzymają „okres przejściowy” wynoszący 36 miesięcy, aby dostosować swoją technologię do przepisów.

Co się zmieni dla biznesu i państwa?

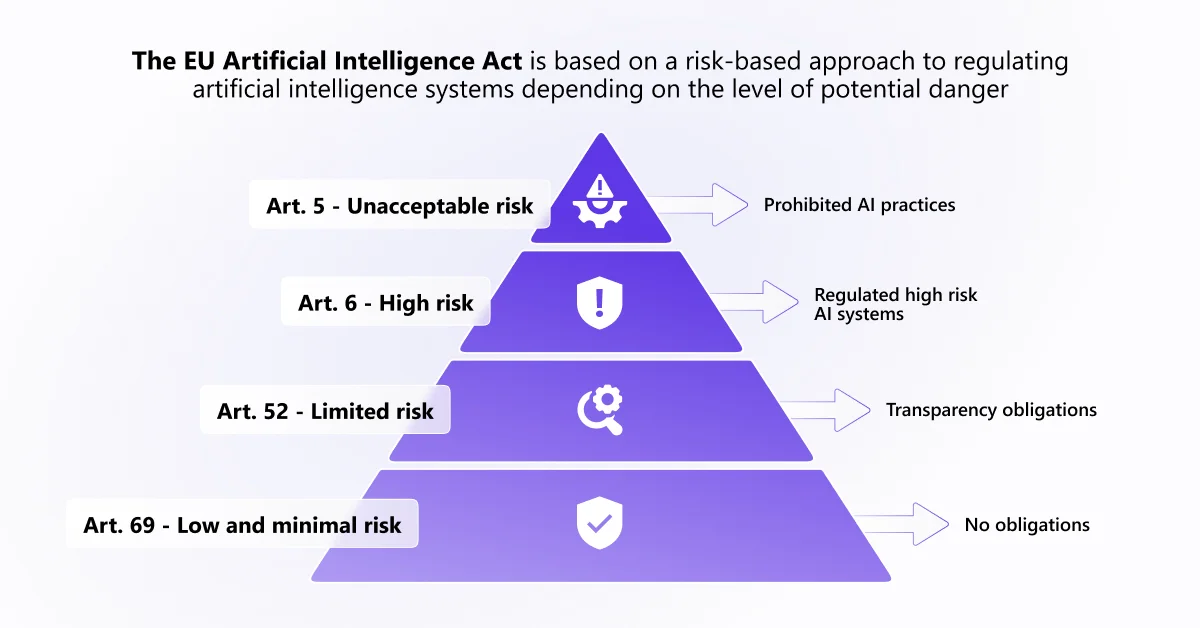

Artificial Intelligence Act opiera się na podejściu opartym na ocenie ryzyka, które rozróżnia główne kategorie systemów sztucznej inteligencji w oparciu o prawdopodobieństwo wystąpienia szkody i potencjalny poziom jej poważności:

- Niedopuszczalne ryzyko. Zakazane systemy generatywnej AI obejmują modele z niedopuszczalnym poziomem ryzyka dla bezpieczeństwa, praw lub podstawowych wolności człowieka, które mogą:

- manipulować zachowaniem ludzi lub grup wrażliwych;

- dokonywać społecznego rankingu ludzi na podstawie zachowania, statusu społeczno-ekonomicznego lub cech osobistych;

- przeprowadzać biometryczną identyfikację oraz kategoryzację ludzi, w tym rozpoznawanie twarzy.

- Wysokie ryzyko. Takie systemy wymagają ścisłej regulacji i nadzoru przez cały cykl życia. Na przykład są to modele, które mogą być używane w:

- infrastrukturze krytycznej (transport);

- edukacji i szkoleniach oraz wpływać na dostęp do nich, zatrudnieniu;

- medycynie (AI w chirurgii z wykorzystaniem technologii robotycznych);

- świadczeniu usług prywatnych i publicznych (ocena zdolności kredytowej);

- działania organów ścigania, które mogą naruszać podstawowe prawa człowieka;

- zarządzaniu migracją, udzielaniu azylu i kontroli granic;

- wymiarze sprawiedliwości i procesach demokratycznych.

- Ograniczone ryzyko. Systemy AI z tej kategorii nadal wymagają przestrzegania pewnych środków bezpieczeństwa, takich jak ostrzeżenia o ich użyciu, ale normy regulacyjne są mniej rygorystyczne. Przykładem są chatboty do obsługi klienta oparte na AI lub systemy do wykrywania emocji i tworzenia treści typu deepfake.

- Minimalne ryzyko. Modele generatywnej AI w tej kategorii podlegają najmniejszym wymogom regulacyjnym. Przykładem są podstawowe filtry e-mailowe klasyfikujące wiadomości jako spam.

- Minimal Risk. Such generative AI models are subject to the slightest regulatory burden. This includes, for example, basic email filters that classify messages as spam.

Systemy sztucznej inteligencji ogólnego przeznaczenia (GPAI), takie jak Copilot, ChatGPT i Gemini, mogą stwarzać systemowe ryzyko i muszą przechodzić dokładny proces oceny. Dodatkowo, będą podlegać wymogom dotyczącym przejrzystości i prawa autorskiego UE, a także zapobieganiu generowaniu nielegalnych treści. Treści wygenerowane przy użyciu AI muszą być odpowiednio oznaczone, a odbiorcy poinformowani. Marketingowcy, bierzcie to pod uwagę!

Nowe organy regulacyjne

Komisja Europejska ma teraz pełne prawo nakładać na firmy grzywny za naruszenie przepisów w wysokości do 35 milionów euro lub 7% rocznego globalnego dochodu firmy. Dla małych i średnich przedsiębiorstw przewidziano niższą skalę kar, uwzględniając ich interesy oraz zdolność ekonomiczną.

Nadzór nad przestrzeganiem przepisów będzie sprawował nowo utworzony Urząd ds. Sztucznej Inteligencji (AI Office) na poziomie UE. Urząd ten będzie miał uprawnienia do oceny modeli ogólnego przeznaczenia (GPAI) i wspierania krajowych organów w nadzorze nad rynkiem wysokiego ryzyka systemów generatywnej AI. Zostanie również powołana Europejska Rada ds. Sztucznej Inteligencji, składająca się z przedstawicieli państw członkowskich UE, odpowiedzialna za doradztwo, opinie i rekomendacje.

Co powinni zrobić przedsiębiorcy? Wnioski i rekomendacje

Jeśli jesteś dostawcą, deweloperem, importerem, dystrybutorem lub osobą, której dotyczą systemy sztucznej inteligencji, musisz upewnić się, że Twoje praktyki w zakresie sztucznej inteligencji są zgodne z nowymi wymogami prawa. Oto kilka praktycznych kroków, które można podjąć już teraz:

Oceń ryzyko. Upewnij się, że Twoja organizacja posiada kompleksowy system zarządzania ryzykiem, aby spełnić wymagania Ustawy o sztucznej inteligencji i zastosować odpowiednie wymagania dotyczące jakości danych, dokumentacji technicznej, nadzoru ludzkiego, zaangażowania interesariuszy itp.

Przejrzystość i zrozumiałość systemów AI. Informowanie użytkowników i innych interesariuszy o wykorzystaniu sztucznej inteligencji, jej możliwościach i ograniczeniach oraz zapewnienie im możliwości kwestionowania i korygowania decyzji opartych na sztucznej inteligencji.

Zwiększ świadomość. Informuj i szkol swoich pracowników w zakresie korzyści i ryzyk związanych ze sztuczną inteligencją.

Budowanie standardów etycznych. Promuj zrównoważone i etyczne wykorzystanie sztucznej inteligencji, integrując to ze strategią swojej organizacji.

Trzymanie ręki na pulsie. Bądź na bieżąco z nowymi zmianami regulacyjnymi, aby przewidzieć ich wpływ na Twoją firmę i na czas zadbać o zgodność z przepisami.

AI Act jest częścią nowej europejskiej strategii cyfrowej, która dotyka innych aspektów cyfrowego świata oprócz sztucznej inteligencji. Podobnie jak RODO, CCPA i inne przepisy, ustawa będzie dotyczyć wszystkich firm planujących działalność na rynku europejskim. Ma ona na celu stworzenie ekosystemu AI zgodnego z europejskimi wartościami i przepisami oraz wspierającego innowacje i konkurencyjność.

My jako partnerzy Microsoft śledzimy rozwój sytuacji i promujemy etyczną dystrybucję i wykorzystanie generatywnej sztucznej inteligencji, która staje się obecnie integralną częścią rozwiązań, aplikacji i usług zarówno Microsoft, jak i SMART business.

Jakie jest stanowisko Microsoft w sprawie stworzenia modelu zarządzania i regulacji technologii AI w Europie? Microsoft aktywnie uczestniczy w dyskusjach na temat regulacji sztucznej inteligencji, przedstawiając propozycje oparte na swoich doświadczeniach w pracy z klientami i własnym programie odpowiedzialnej sztucznej inteligencji (responsible AI program).

Korporacja Microsoft rozszerzyła swój pięciopunktowy plan, który po raz pierwszy przedstawiła w 2019 roku, aby pokazać, jak współgra on z dyskusjami na temat ustawy AI w UE. Plan obejmuje takie zasady jak odpowiedzialność, przejrzystość, sprawiedliwość, niezawodność oraz bezpieczeństwo.

W swoim oficjalnym blogu Microsoft deklaruje, że wspiera taki system regulacyjny w Europie, który skutecznie rozwiązywałby kwestie bezpieczeństwa i chronił podstawowe prawa, jednocześnie wspierając innowacje, które zapewnią konkurencyjność Europy na poziomie globalnym.

Korporacja zobowiązała się do wdrożenia systemu zarządzania ryzykiem sztucznej inteligencji (NIST) oraz innych międzynarodowych standardów bezpieczeństwa, które zostaną określone w Ustawie o sztucznej inteligencji.

Wszystkie produkty z portfolio SMART business spełniają wymagania zarówno lokalnych, jak i międzynarodowych standardów i przepisów, co ogranicza ryzyko dla klientów i pomaga bezpiecznie oraz zgodnie z przepisami zarządzać procesami biznesowymi. Zawsze jesteśmy gotowi stać się Twoim zaufanym partnerem IT i zapewnić wsparcie podczas i po wdrożeniu:

- ERP do automatyzacji procesów biznesowych;

- Wewnętrznego portalu korporacyjnego;

- Microsoft 365 i Copilot dla Microsoft 365;

- Programów adaptacyjnych Microsoft 365;

- Microsoft Azure;

- Prognozowania popytu;

- Kompleksowej ochrony bezpieczeństwa informatycznego firmy;

- Systemów elektronicznego obiegu dokumentów;

- Systemów zarządzania magazynem.